【Python】データの準備から学ぶPyTorch:標準データセットの活用方法

最近、PyTorchを使ってプロジェクトを始めようと思っているけど、データの準備でつまづいているんだにゃ。どうしたらいいにゃ。

大丈夫だよ、PyTorchには標準データセットがあって、それを使うとスタートがとても簡単になるんだ。

本当かにゃ?でも、標準データセットって限られているんじゃないかにゃ?

そんなことないよ。まずは、PyTorchのデータローディングシステムを理解しよう。データセットとデータローダーの概念から始めるのがいいね。

データセットとデータローダーって何なんだにゃ?

データセットは、PyTorchで使用するデータのコレクションだよ。そして、データローダーは、そのデータセットをネットワークに効率的に供給するための仕組みなんだ。

なるほど、だからデータの準備が重要なんだにゃ!

そうなんだ!そして、PyTorchの標準データセットは、このプロセスを簡単にしてくれる。例えば、MNISTやCIFAR-10など、すぐに使えるデータセットがたくさんあるよ。

それはいいんだにゃ!これで、PyTorchでのプロジェクトをスムーズに始められそうだにゃ。

それから、自分のデータセットを作成する方法も学ぶといいよ。それによって、PyTorchの可能性をさらに広げることができるからね。

はじめに

ディープラーニングの世界において、正確で効果的なモデルトレーニングを行うためには、データセットの適切な準備と前処理が不可欠です。このブログでは、データセットの準備と前処理の重要性について掘り下げ、PyTorchを使用してこれらのステップをどのように行うかについて説明します。

データセットの準備の重要性

モデルトレーニングにおける最初のステップは、適切なデータセットを選択し、これをモデルが理解できる形式に準備することです。このプロセスには、データの収集、クレンジング、そして構造化が含まれます。適切に準備されたデータは、モデルが実世界の問題をより効果的に学習し解決するのに役立ちます。

前処理の役割

データセットが準備されたら、次に行うべきは適切な前処理です。これには、データの正規化、リサイズ、場合によってはデータ拡張などが含まれます。これらの前処理手順は、モデルのトレーニング効率を向上させ、最終的なパフォーマンスに大きな影響を与えます。

PyTorchのツール

PyTorchは、これらのステップを容易にするための強力なツールを提供します。

torch.utils.data.Datasetとtorch.utils.data.DataLoaderは、データセットの管理とバッチ処理を行う際に特に有用です。これらのツールを使うことで、データを効率的にロードし、前処理し、モデルに供給することが可能になります。

データセットの選択

ディープラーニングを学び始める際には、よく整理されていて、広く利用されている標準データセットの使用が推奨されます。これには、MNISTやCIFAR-10などが含まれます。これらのデータセットは、基本的な概念を理解するのに理想的で、多くの教育的なリソースで使用されています。

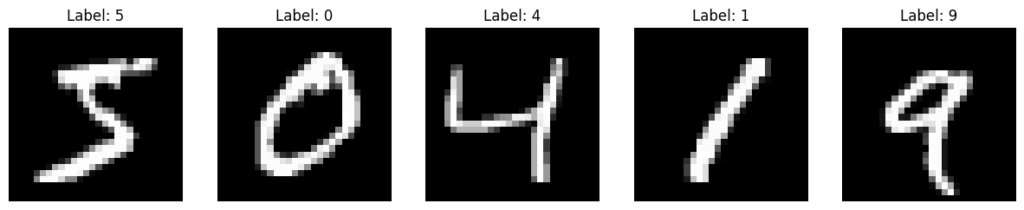

MNISTデータセット

MNISTは、手書き数字(0から9まで)の画像で構成されるクラシックなデータセットです。このデータセットは、画像認識の入門に最適です。

PyTorchでMNISTを読み込むには、torchvisionライブラリを利用します:

import torchvision

from torchvision import transforms

# トランスフォーム(前処理)の定義

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

# MNISTデータセットの読み込み

train_dataset = torchvision.datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = torchvision.datasets.MNIST(root='./data', train=False, download=True, transform=transform)

CIFAR-10データセット

CIFAR-10は、10種類の異なるカテゴリ(例:飛行機、自動車、鳥、猫、鹿、犬、カエル、馬、船、トラック)の32×32ピクセルのカラー画像を含むデータセットです。このデータセットは、より高度な画像分類のタスクに適しています。

CIFAR-10もPyTorchのtorchvisionを使用して簡単に読み込むことができます:

# CIFAR-10データセットの読み込み

train_dataset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

test_dataset = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

データの前処理

モデルトレーニングの準備として、データセットに適切な前処理を施すことが重要です。前処理ステップは、データをモデルの入力に適した形式に変換し、トレーニングの効率と効果を向上させるために行います。

前処理の重要なステップ

一般的な前処理手順には以下のようなものがあります:

- 正規化: データを特定の範囲や分布にスケーリングすることで、モデルの学習を安定させ、加速します。

- リサイズ: 画像データの場合、一定のサイズにリサイズすることが多く、モデルの入力サイズに合わせる必要があります。

- データ拡張: ランダムな変換を適用してデータを増やし、モデルの汎用性を高めます。例えば、画像の回転、反転、色調整などがあります。

PyTorchのtransformsモジュール

PyTorchではtransformsモジュールを使用して、これらの前処理ステップを簡単に実装できます。以下は、一般的な前処理手順の例です:

from torchvision import transforms

# 前処理手順の定義

transform = transforms.Compose([

transforms.Resize((32, 32)), # 画像サイズのリサイズ

transforms.ToTensor(), # 画像をPyTorchテンソルに変換

transforms.Normalize((0.5,), (0.5,)) # データの正規化

])

# 前処理を適用してデータセットをロード

train_dataset = torchvision.datasets.MNIST(root='./data', train=True, download=True, transform=transform)このコードでは、MNISTデータセットに対してリサイズ、テンソル変換、正規化という前処理を適用しています。

データローダーの設定

データの前処理が完了したら、次に重要なのはtorch.utils.data.DataLoaderを使用してデータをモデルに効率的に供給することです。DataLoaderはデータのバッチ処理、シャッフリング、マルチスレッドを通じた並列データロードなどの機能を提供します。

DataLoaderの役割

DataLoaderは、大量のデータを扱いやすくするために重要な役割を果たします。特に、以下の機能が重要です:

- バッチ処理: データを小さなバッチに分割し、メモリ効率を向上させます。

- シャッフリング: データの順番をランダムにすることで、モデルの汎用性を高めます。

- マルチスレッドロード: データのロードを複数のスレッドで並列に実行し、トレーニング時間を短縮します。

設定例

以下は、MNISTデータセットを用いたDataLoaderの設定例です:

from torch.utils.data import DataLoader

# データローダーの設定

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True, num_workers=2)

test_loader = DataLoader(test_dataset, batch_size=64, shuffle=False, num_workers=2)この例では、トレーニングデータセット用とテストデータセット用の2つのDataLoaderを定義しています。各ローダーは64のバッチサイズを使用し、トレーニングデータはシャッフルされ、2つのワーカースレッドを使用してデータをロードします。

まとめ

このブログでは、ディープラーニングモデルの成功に不可欠なデータセットの準備と前処理の重要性について詳しく見てきました。PyTorchを用いたこれらのステップは、モデルのトレーニングと性能に大きな影響を与えるため、適切な実装が重要です。

データセットの準備と前処理の重要性

- 適切なデータセットの選択: データセットは、モデルが学習する基礎となります。初心者には、MNISTやCIFAR-10のような標準データセットの利用が推奨されます。

- 効果的な前処理: データの正規化、リサイズ、データ拡張は、モデルがデータを効率的に処理し、より良い結果を得るのに役立ちます。

- 効率的なデータロード:

DataLoaderを使用することで、バッチ処理、シャッフル、並列ロードが可能になり、トレーニングプロセスがスムーズになります。

以上、データの前処理について見てきましたが、データセットの準備と前処理は、どんな複雑なプロジェクトでも基本となるステップです。小さなデータセットで基本を学んだ後、より複雑なデータセットに移行して見てください。

また、理論だけでなく、実際のデータを使って前処理とデータロードのプロセスを実践することで、理解を深めることができます。繰り返し練習し、学びを深めてくださいね。